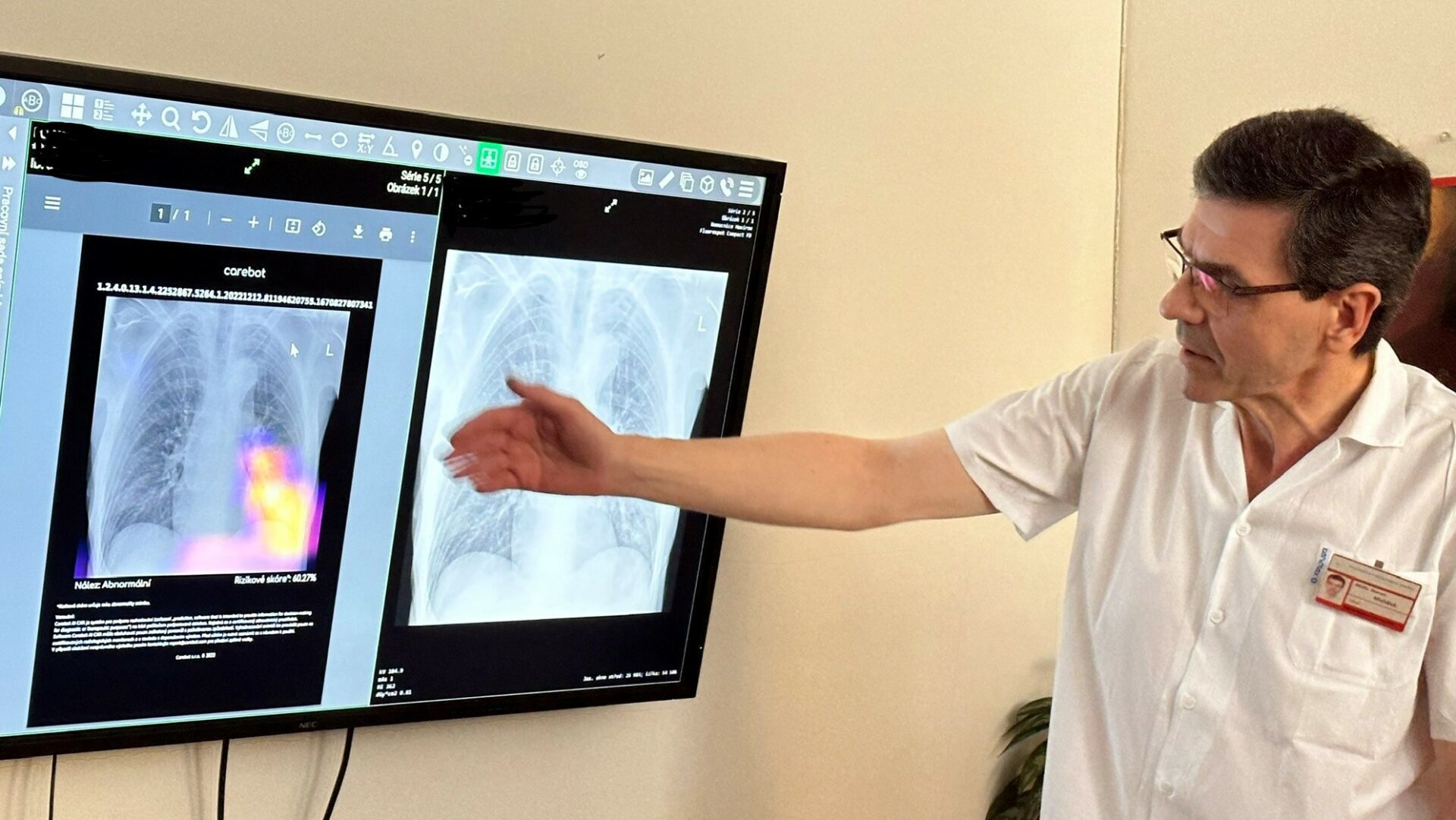

Má to ale jeden háček: Protože různé modely AI ne vždy rozumějí lékařským souvislostem, řekněme „vychytávkám“ v medicíně, a především postrádají zkušenosti jednotlivých lékařů, bývají někdy ve svých „analýzách“ hodně kreativní.

Odborníci z lékařského centra Dartmouth-Hitchcock v americkém státě New Hampshire zkoumali, jak náchylné jsou systémy k takovému „zkratkovitému učení“. Výsledek ohromil. Nejprve nakrmili neuronovou síť s přibližně 18 000 rentgenovými snímky kolen, uvádí německý list Bild. Vědci umělé inteligenci rovněž poskytli informace o stravě příslušných pacientů.

Poté AI požádali, aby pomocí rentgenových snímků určila, kolik piva dotyčný pacient za poslední rok vypil. Druhý model měl určit, kolik snědl mexického fazolového pyré. Obě potraviny pochopitelně nemají z lékařského hlediska s potíži s koleny nic společného. Přesto se umělá inteligence domnívala, že rozpoznala souvislost.

A v mnoha případech měla dokonce pravdu. U fazolového pyré dosáhla míra shody 63 procent, u piva dokonce 73 procent, tedy bezmála tři čtvrtiny. „Ukazuje to, jak neuronové sítě dokážou dělat překvapivě přesné předpovědi, které jsou zcela z ničeho. Nemají vůbec žádné medicínské nebo věrohodné vysvětlení,“ říkají vědci.

Jinými slovy, úlohy řeší vyhodnocováním náhodných korelací, místo aby skutečně rozpoznávaly existující korelace. Systémy AI zřejmě analyzovaly i informace, které neměly s kolenem nic společného, s největší pravděpodobností umístění rentgenového snímku, pohlaví a etnickou příslušnost.

Ale i poté, co bylo odborníky ze snímků odstraněno vypovídající označení, se míra shody téměř nesnížila. Horlivost, s jakou se umělá inteligence řídí zkratkami, označili vědci za ohromující. „O to důležitější je přísně kontrolovat analýzy a diagnózy podporované umělou inteligencí – zejména pokud jde o lékařské otázky,“ uzavřel Bild.